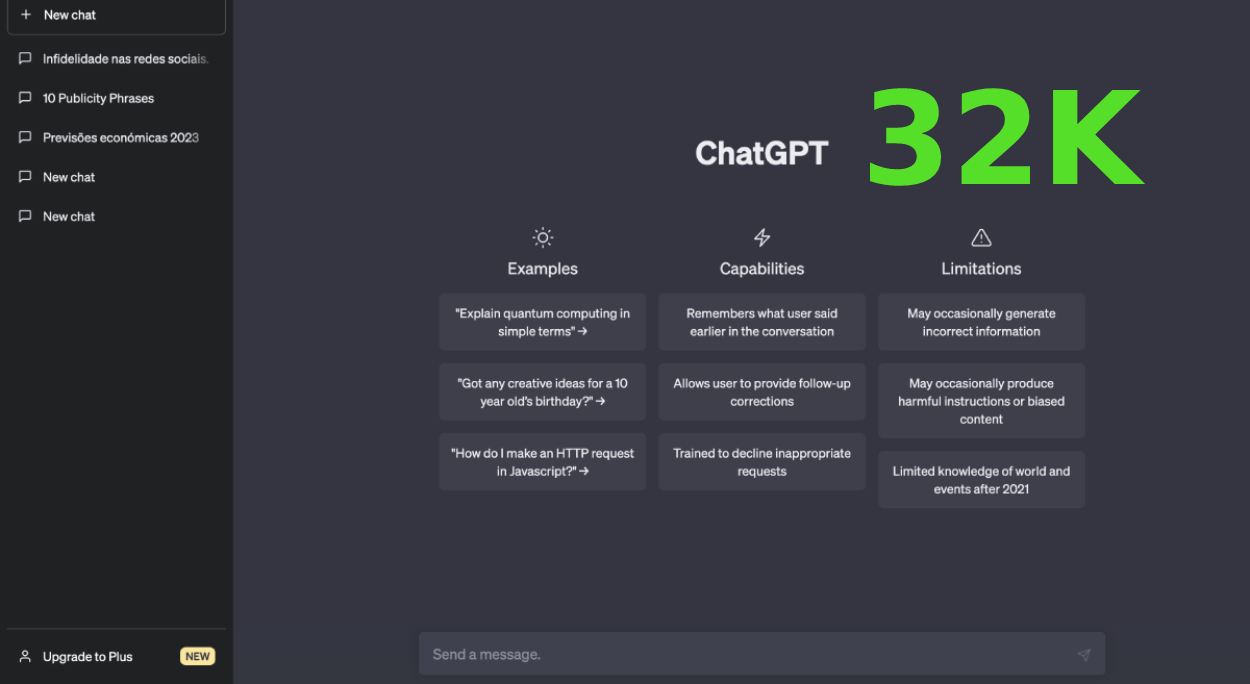

GPT-4 32K é uma versão melhorada do GPT-4, o modelo de linguagem multimodal mais recente da OpenAI. A principal diferença entre os dois modelos é o comprimento do contexto (Prompt), que é o comprimento do texto de entrada mais o número máximo de tokens na saída. O modelo padrão do GPT-4 oferece 8.000 tokens para o contexto. O GPT-4 32K oferece 32.000 tokens, o que significa que pode analisar muito mais texto em uma solicitação. Isso pode melhorar a fiabilidade, criatividade e capacidade de lidar com instruções mais complexas do que o GPT-4 padrão.

Para usar o GPT-4 32K, você precisa de um dos seguintes requisitos:

- Ter acesso à API do GPT-4, que é idêntica à API do GPT-3.5-turbo, exceto pela API de ChatCompletion. Pode-se inscrever na lista de espera do GPT-4 aqui: https://openai.com/research/gpt-4/#join-api-waitlist

- Usar a API de ChatCompletion, que é uma nova API dedicada para interagir com os modelos ChatGPT e GPT-4. Você precisa criar um deployment destes modelos e especificar uma versão do modelo.

O GPT-4 32K gasta mais tokens que a versão GPT-4 ?

Não necessariamente. O GPT-4 32K tem a capacidade de usar mais tokens do que o GPT-4, mas isso depende do tamanho do texto de entrada e da quantidade de texto que você quer gerar. Se o texto de entrada for menor que 8.000 tokens e você quiser gerar menos de 8.000 tokens, o GPT-4 32K usará a mesma quantidade de tokens que o GPT-4. Se o texto de entrada for maior que 8.000 tokens ou você quiser gerar mais de 8.000 tokens, o GPT-4 32K usará mais tokens que o GPT-4.

O que significa ter 32K ?

Ter 32K significa ter 32.000 tokens de comprimento de contexto. Um token é uma unidade básica de texto que o modelo usa para processar e gerar linguagem. Um token pode ser uma palavra, um caractere, um símbolo ou uma parte de uma palavra. O número de tokens que um texto tem depende do tipo de tokenização que o modelo usa. Por exemplo, o texto “Olá, mundo!” tem 3 tokens se usarmos a tokenização por palavras, mas tem 12 tokens se usarmos a tokenização por caracteres.

Como posso contar os tokens de um texto?

Existem algumas formas de contar os tokens de um texto, dependendo da ferramenta que você usa. Uma forma é usar o NLTK, uma biblioteca de Python para processamento de linguagem natural. O NLTK tem uma classe chamada FreqDist que pode calcular a frequência dos tokens em um texto. Você pode usar o método N() para contar quantos tokens um texto contém.

Com esta nova versão do chatGTP-4 passamos a ter a capacidade de inserir Prompts muito mais complexas e muito mais extensas, fazendo com que a qualidade de resposta desta ferramenta da OPENAI seja muito mais elabora de de qualidade redobrada.

Trabalho na área de tecnologia e informática desde 1993 e na área de internet como blogger e webmaster desde 2004. Adoro tecnologia, gadgets, cinema e viagens. Adoro investigar e escrever sobre tecnologias, viagens e carros.

Publicar comentário